I artiklen her dykker vi ned i, på hvilke måder AI med overvejende sandsynlighed kommer til at forandre internettet gevaldigt i løbende af de kommende år. Ligeledes giver vi en række eksempler på, hvordan AI allerede har forandret internettet.

Siden ChatGPT blev lanceret i november 2022, har AI været ‘talk of the town’, og allerede nu har AI sat sit aftryk på adskillige områder, eksempelvis på jobmarkedet, men så sandelig også internettet.

Der er næppe tvivl om, at AI kommer til at ændre internettet endnu mere, end vi allerede har set, og i denne artikel får du indblik i en række sandsynlige scenarier for, hvordan AI kan revolutionere og omforme internettet.

Inden vi kigger i krystalkuglen, kaster vi dog lys over en række af de områder af internettet, som AI allerede har influeret.

Indholdsfortegnelse

En del online-indhold har allerede nu AI som enten hoved- eller medskaber

I løbet af de seneste år er der blevet lanceret adskillige AI’er, der kan udarbejde tekst-, billed- og/eller videoindhold på et relativt højt niveau, og da AI’er er både yderst effektive, relativt billige at benytte og ikke bliver udmattede eller trætte som os mennesker, har vi – ikke så overraskende – været vidne til en udvikling, hvor en større og større andel af det indhold, der produceres til online-platforme, enten har en eller flere AI’er som hoved- eller medskaber(e).

Dette dokumenteres i adskillige studier, blandt andet et, der hævder, at mængden af AI-indhold på den store artikel- og blogplatform Medium har været voldsomt stigende siden 2022; det samme gør sig gældende for indholdet på platformen Quora.

Disse platforme er naturligvis ikke de eneste, der bugner med indhold, der enten er produceret af eller i samarbejde med en eller flere AI’er.

Dette bemærkes også af Peter Svarre, der er ekspert i blandt andet AI og digitale medier, og Johannes Bjerva, der er professor ved Aalborg Universitet i blandt andet AI.

“Der er masser af sites på nettet, som er fuldt genereret af AI, og flere og flere produktwebsider bliver fyldt med produktbeskrivelser, som er skrevet og versioneret af AI,” forklarer Peter Svarre, mens Johannes Bjerva forklarer:

“Dels er meget bruger-genereret indhold skrevet af sprogmodeller, og dels er meget ‘rigtigt’ indhold genereret.”

Derfor er der overvejende stor sandsynlighed for, at en eller flere AI’er har været med- eller hovedskaber(e) af noget af det indhold, du konsumerer, når du læser nyhedsartikler, produktbeskrivelser, LinkedIn-opslag, blogartikler samt Reddit-kommentarer, eller sågar når du ser videoer og/eller billeder på sociale medier.

Den type content – altså video- og billedindhold – kan AI’er – som vi også allerede har bemærket en gang – nemlig også producere, og faktisk findes der allerede nu generative AI’er, der kan kreere video- og billedindhold, som forekommer at være meget virkelighedstro.

Dette har blandt andet ført til, at flere personer og virksomheder har haft succes med at skabe populære AI-influencere, altså influencere, der ikke er ægte, men som derimod er skabt ved hjælp AI’er.

Hvad er generativ AI?

Generativ AI refererer til kunstig intelligens, der kan skabe nyt indhold, såsom tekst, billeder, videoer eller musik, baseret på mønstre og strukturer lært fra enorme datamængder.

Eksempler på generative AI’er inkluderer avancerede sprogmodeller som ChatGPT, der genererer menneskelignende tekst, og billedgeneratorer som Midjourney, der skaber realistiske billeder med afsæt tekstbeskrivelser – såkaldt prompts.

Flere af disse AI-influencere er – målt på antallet af følgere – blevet ganske succesfulde, og man skal som regel have et et ret skarpt syn, hvis man – med afsæt i det billed- og video-materiale, man finder på disse influenceres profiler – skal være i stand til at afkode, at der ikke er tale om ægte mennesker.

En påstand, der bakkes op af flere studier, som dokumenterer, at vi mennesker relativt ofte ikke er i stand til at gennemskue, hvornår noget billed- og/eller videoindhold er skabt ved hjælp af AI.

Et eksempel på en af de succesfulde influencere – som er skabt ved hjælp af AI – er den virtuelle model, Aitana Lopez, der er skabt af modebureauet The Clueless, og som i skrivende stund (marts 2025) har mere end 350.000 følgere på Instagram.

Mere og mere online-indhold kommer i fremtiden til at blive skabt med hjælp fra AI

I takt med at de forskellige generative AI’er forbedres og forfines, og der kommer flere AI’er til, er det kun realistisk, at en endnu større mængde af det indhold, der i fremtiden bliver udgivet online, kommer til at være skabt af eller i samarbejde med en eller flere AI’er.

Dette kan – ifølge Peter Svarre – få adskillige konsekvenser, hvoraf nogle er ganske ubetydelige, mens andre er af mere alvorlig karakter.

“Nogle gange er effekterne af AI jo ret uskyldige og nyttige, for eksempel når AI bruges til at oversætte produktbeskrivelser til ens eget sprog. Men når vi taler fulde mediesites, hvor alt indholdet genereres af AI, så begynder det at blive problematisk,” fortæller Peter Svarre, inden han anekdotisk fortsætter:

“Jeg faldt for nyligt over et investeringswebsite, der gav råd om investering, hvor alt indholdet var skabt af AI. Formålet var udelukkende at lokke folk til for at tjene penge på annoncering med noget indhold, som i bund og grund var fuldstændigt random og ligegyldigt. Derudover er det også problematisk med propaganda-websites, der understøtter bestemte politiske dagsordener.”

Også Johannes Bjerva pointerer, at det – at mere og mere indhold skabes enten af eller ved hjælp af AI – kan være problematisk på flere områder. Eksempelvis kan det være problematisk i forhold til indholdets troværdighed. Derudover vil AI-skabt indhold videreformidle forskellige bias, hvilket også kan give anledning til panderynker.

“En sprogmodel, der er trænet på Reddit- og Twitter-indhold vil indeholde en masse bias, som en “almindelig” dansk bruger nok ikke vil finde særlig passende,” forklarer Johannes Bjerva og fortsætter:

“Nogle gange er det transparent, når indhold er skabt via AI – f.eks. laver nrk.no – den norske pendant til dr.dk – automatiske sammenfatninger af alle artikler. Andre gange er det ikke – og dét kan være meget problematisk, bl.a. når det gælder troværdighed.”

Ovenstående kan indiskutabelt have store negative konsekvenser for internettets brugere, og når det kommer til internettet i sig selv, kan AI – ifølge Peter Svarre – også føre til, at vi ender et dystopisk sted.

“I værste fald kan det – hvis mere og mere indholdsproduktion varetages af AI’er – jo være enden på internettet, for AI’er kan per definition ikke skabe noget nyt. Et 100% AI-genereret internet ville være et dødt sted, der bare vegeterede på sig selv,” forklarer han, inden han afslutter på en lidt mere positiv note:

“Men mere realistisk er nok, at tingene finder en naturlig balance, hvor der stadig vil være menneskeskabt indhold – og måske bliver netop den slags indhold mere værdifuldt, fordi det bliver mere sjældent.”

Også Johannes Bjerva pointerer, at der – for internettet som helhed – kan være udfordringer forbundet med, at mere og mere indhold udarbejdes af AI’er.

“Jo mere indhold som genereres af LLM’er (red: Large Language Model’er), desto mere LLM-genereret indhold vil der være i træningsmateriale for den næste LLM. Det resulterer i et form for “ekko-kammer”, hvor eksempelvis bias fra Reddit genskabes og forstærkes,” fortæller Johannes Bjerva.

Måden, hvorpå flertallet informationssøger online, kommer muligvis til at forandre sig

I mange år har mange af os søgt viden og information online på følgende måde:

- Vi har indtastet en forespørgsel eller et spørgsmål på Google eller en anden søgemaskine.

- Derefter har vi besøgt et eller flere af de søgeresultater, som søgemaskinen har præsenteret os for, og via disse har vi forhåbentligt fundet svar på vores spørgsmål/forespørgsel.

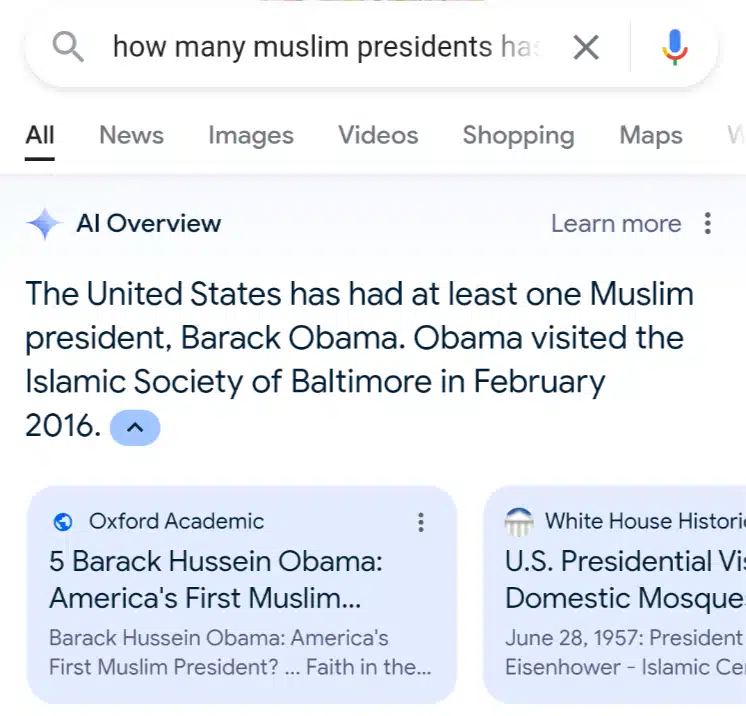

Med fremkomsten af sprogmodeller som ChatGPT og Gemini er det blevet muligt at effektivisere ovenstående informationssøgningsproces.

Disse sprogmodeller er nemlig i stand til at besøge de forskellige relevante kilder, som en traditionel søgemaskine vil foreslå en bruger at tjekke, efter brugeren har indtastet en forespørgsel, og sprogmodellerne er ikke blot i stand til at besøge kilderne; de er også i stand til at “læse samt forstå” indholdet fra dem, og – med afsæt i det af kildernes indhold, som modellerne anser som værende det bedste og mest relevante – kreere målrettede og præcise svar.

At AI-teknologi muliggør, at online informationssøgning kan forbedres og effektiviseres, er også noget, som verdens største søgemaskine Google har erkendt.

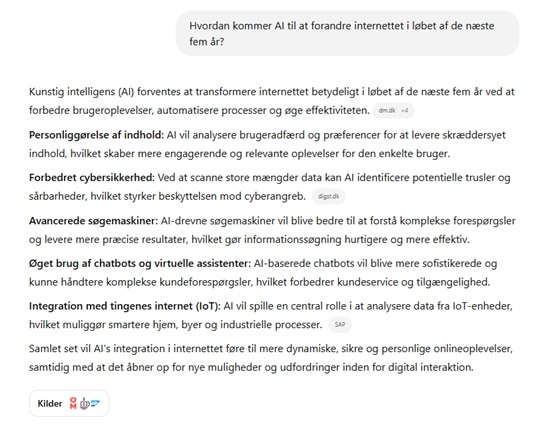

Denne erkendelse har ført til, at Google i de seneste år har eksperimenteret med forskellige AI-tiltag, hvor det mest bemærkelsesværdige er, at søgemaskinen i en række lande har introduceret AI-svar til de søgeforespørgsler, hvor søgemaskinen vurderer, at netop et AI-svar er det, der bringer mest værdi for den søgende.

Helt konkret betyder dette, at Google ved en række søgeforespørgsler i nogle lande – ved hjælp af AI – genererer målrettede, præcise svar, som er sammenfatninger af pointer og indhold fra adskillige forskellige kilder.

Der er umiddelbart ingen tvivl om, at søgning, der involverer AI på den måde, som vi netop har beskrevet, er mere effektivt og brugervenligt for forbrugeren. I hvert fald når den type søgninger fungerer upåklageligt, og svaret altid er faktuelt korrekt, hvilket ikke er tilfældet endnu, men det vender vi tilbage til senere.

Lige nu vil vi nøjes med at konstatere, at det ikke er en voldsom fjern tanke, at vi i fremtiden i højere grad end nu kommer til at få vores information serveret via ganske få platforme, eksempelvis ChatGPT og Google.

Der er dog en række instanser, der ser en fremtid, hvor dette er tilfældet, som et skrækscenarium, og disse vil uden tvivl gøre, hvad de kan for at forhindre og forsinke, at vores forudsigelser bliver til virkelighed.

Derudover kommer vi heller ikke udenom, at der knytter sig adskillige problemer til AI-sprogmodeller på det udviklingsstadie, som disse befinder sig på lige nu. Problemer, der gør, at det i dag vil være decideret uforsvarligt at, helt ukritisk, foretage samtlige af sine videns- og informationssøgninger via ChatGPT eller en anden sprogmodel.

Begge dele er noget, som vi vil kaste lys over i løbet af de kommende afsnit.

Indholdsudgivere vil forsøge at forhindre, at det scenarie, vi har beskrevet, bliver til virkelighed

Ifølge en artikel på Business Insider foretages der hvert år mere end fem billioner Google-søgninger, hvilket svarer til 13,7 millarder søgninger dagligt.

Det er klart, at det ikke er samtlige af disse søgninger, der resulterer i trafik til indholdsudgivere, da Google allerede nu i mange sammenhænge serverer svar på søgeforespørgsler direkte i søgemaskinens interface, hvilket hyppigt resulterer i de såkaldt “zero click-searches”.

Hvorom alting er, så leverer Google stadigvæk uhørt meget organisk trafik til alverdens hjemmesider, og en anseelig mængde forretninger, der opererer helt eller delvist online, er afhængige af at opretholde den mængde organiske Google-trafik, de i dag får, hvis de skal forblive bæredygtige.

Derfor ser indholdsudgivere – ikke så overraskende – som regel skævt til initiativer og udviklinger, der med al sandsynlighed vil føre til fald i mængden af organisk trafik fra Google og andre søgemaskiner.

Af blandt andet denne grund er mange indholdsudgivere da naturligvis ej heller synderligt positivt stemte over for en udvikling, hvor sprogmodeller ender med at levere så gode og grundige svar, at den informationssøgende forbruger sjældent vil have behov for at klikke sig videre fra disse sprogmodeller til de kilder, som sprogmodellernes svar tager afsæt i.

Denne problematik har været italesat af adskillige indholdsudgivere i løbet af de seneste år, lige såvel som en del indholdsudgivere har anklaget Google samt en række af de andre sprogmodeller for at være plagiatorer.

Remember this study about how LLM generated research ideas were rated to be more novel than expert-written ones?

— Danish Pruthi (@danish037) February 25, 2025

We find a large fraction of such LLM generated proposals (≥ 24%) to be skillfully plagiarized, bypassing inbuilt plagiarism checks and unsuspecting experts. A 🧵 https://t.co/u1C9yN2KvD

Please #GoogleBard explain how this is not plagiarism? You refer to data from our article but say "in our testing" (implying that the 'our' is Google) with no citation. Then, when I ask you who "our" is, you admit you stole it from us. CC @lilyraynyc pic.twitter.com/M0X1aHtLaW

— Avram Piltch (@geekinchief) March 22, 2023

Nogle af de utilfredse indholdsudgivere har i øvrigt ikke blot nøjedes med at råbe kritisk op, men er gået så vidt, at de har sagsøgt de virksomheder, der benytter sig af eller driver AI-sprogmodeller.

Dette så vi et eksempel på i februar 2025, hvor Chegg sagsøgte Google med en påstand om, at AI-svar havde skadet Cheggs trafik og indtjening.

Derudover lagde New York Times i 2024 sag an mod ChatGPT grundet krænkelse af ophavsret.

Ifølge Birgit Liin, der er professor ved Juridisk Institut på Aarhus Universitet, er der endnu ikke nogen danske (i hvert fald ikke offentliggjorte) domme om krænkelse af ophavsret pga. AI-træning, og da udenlandske retssager baseres på udenlandsk ret, både materielt og processuelt, ønsker hun ikke at tage stilling til sådanne sagers mulige udfald.

Dog pointerer hun, at det kan være et juridisk problem, at AI-modeller er blevet trænet på indhold uden forudgående tilladelse hertil og forklarer, at den danske ophavsretslov er blevet modificeret med henblik på at følge AI-udviklingen.

“Der er i ophavsretsloven nu indsat bestemmelser om tekst- og datamining (ophavsretslovens §§ 11b-c), hvorefter værker lovligt kan anvendes til dette formål, medmindre rettighedshaveren udtrykkeligt har udelukket det. Bestemmelsernes formål er at sikre, at systemerne kan “scanne” materiale til træning, og sker det i overensstemmelse med disse bestemmelser, er brugen lovlig,” forklarer Birgit Liin, inden hun afslutter:

“Deri ligger også, at anvendelse af materiale, der ikke er omfattet af bestemmelserne, er ulovlig. Rettighedshaverne må i så fald forfølge deres rettigheder med de sædvanlige retsmidler, som omfatter forbud/påbud, erstatning og eventuelt straf.”

Hvis man indleder et søgsmål som følge af ulovlig AI-datatræning, vil der dog – ifølge Birgit Liin – kunne opstå visse vanskeligheder med at bevise, hvorvidt datamaterialet, der danner grundlag for søgsmålet, nu engang også har været anvendt til ulovlig AI-træning.

Google påstår godt nok, at AI-svar fører til flere klik, men…

Dette lyder jo lovende og positivt for indholdsudgivere, men vores medindehaver, Casper Ellam Schou, der har arbejdet professionelt med SEO i snart syv år, kalder ‘bullshit’ og giver ikke meget for Googles udmelding.

“I løbet af den tid, jeg har beskæftiget mig med SEO, er Google blevet taget i at lyve enormt mange gange, og denne her udmelding er i min optik blot endnu et eksempel på Googles lemfældige omgang med sandheden. Allerede nu er der lavet adskillige undersøgelser, der kaster lys over konsekvenserne af AI-svar i søgeresultaterne, og billedet er entydigt negativt set med udgiver-briller,” forklarer Casper Ellam Schou og fortsætter:

“AI-svar får nemlig – hvilket på ingen måde er overraskende – klikraterne til at falde drastisk. Dette hænger naturligvis sammen med, at den søgende typisk får besvaret sin forespørgsel tilfredsstillende via et AI-svar og derfor ikke har behov for at besøge de kilder, der er blevet brugt til udarbejdelsen af svaret,” fortæller Casper Ellam Schou, inden han afslutter:

“Når Google – af udgivere og andre instanser – bliver bedt om at dele tal, der dokumenterer den omtalte påstand, afviser Google da også konsekvent, hvilket blot styrker min mistanke om, at der er lige så meget sandhedsværdi i Googles udmelding, som der var i Rudy Frederiksens påstand om, at han blot var i færd med at optage en musikvideo med nogle meget unge piger.”

Sprogmodeller er afhængige af dygtige indholdsudgivere for at forblive gode

Som bemærket er der en risiko for, at sprogmodeller med tiden bliver så gode til at organisere og servere viden, så de kilder, der danner grundlag for den viden, som sprogmodellerne serverer, med tiden kommer til at opleve et markant fald i trafik, da kilderne blandt andet ikke længere vil få besøg i samme omfang som tidligere via de traditionelle søgemaskiner.

Mindre trafik betyder med al sandsynlighed mindre omsætning for indholdsudgiverne, og for nogle indholdsudgivere vil en fremtid, som vi har beskrevet, med al sandsynlighed føre til et så stort omsætningstab, at disse indholdsudgiveres forretninger ikke længere vil være bæredygtige.

Sker dette, stopper disse indholdsudgivere med at generere nyt indhold, hvilket på sigt kan blive problematisk for sprogmodellerne. For at forstå hvorfor, er det nødvendigt at forstå, hvordan en sprogmodel fungerer.

Hvordan fungerer en sprogmodel?

En stor sprogmodel, som eksempelvis ChatGPT, er et avanceret AI-system, der er designet til at forstå og generere menneskelignende tekst. ChatGPT – og andre store sprogmodeller – er trænet på enorme mængder tekstdata fra forskellige kilder som bøger, artikler og websteder, og denne træning danner grundlag for, at sprogmodellerne er i stand til at forstå nuancerne i sprog, grammatik og kontekst.

Under træningen lærer sprogmodellerne at forudsige det næste ord i en sætning baseret på de foregående ord. Ved at minimere fejl i disse forudsigelser over store mængder tekst, udvikler modellerne en dyb forståelse af sprogstrukturer og kan udføre opgaver som at besvare spørgsmål, opsummere tekster og oversætte mellem sprog.

Godt så…

Dette betyder altså, at en sprogmodel aldrig vil være bedre end det indhold, som modellen er blevet trænet på.

Hvis en sprogmodel eksempelvis ikke er blevet trænet på indhold om EM-sejren i 1992, vil sprogmodellen af gode grunde ej heller kunne besvare spørgsmål korrekt herom. Sprogmodellen vil muligvis prøve, men svarene vil være forkerte.

Bliver det fremtidsscenarie, hvor sprogmodeller i mange tilfælde bliver endestationen, når flertallet informationssøger, fører dette – hvilket vi har berørt tidligere – med al sandsynlighed til trafikfald for de indholdsudgivere, hvis indhold sprogmodellerne trænes på, og trafikfald for udgivere generelt fører – som vi også tidligere har været inde på – til omsætningstab i et sådant omfang, at nogle indholdsudgivere formentlig ikke længere vil have råd til at producere indhold i fremtiden.

Dette vil muligvis føre til, at mængden af godt indhold, der behandler aktuelle forhold og emner, med tiden vil dale, hvilket selvsagt vil være kritisk for kvaliteten af de svar, som sprogmodellerne vil kunne levere på forespørgsler om aktuelle forhold og emner.

Med andre ord er sprogmodellerne altså afhængige af, at der fremover bliver skabt godt kvalitetsindhold fra udgivere, som disse modeller kan blive trænet på. Derfor er det nærliggende at forestille sig, at de virksomheder, der driver de store sprogmodeller, formentligt befinder sig i lidt af et dilemma lige nu.

Bliver sprogmodellerne alt for gode til at finde, organisere og servere viden for deres brugere, risikerer sprogmodellerne nemlig at bide den hånd, som fodrer dem.

Du kan ikke altid stole på sprogmodellerne

Tidligere bemærkede vi, at der på det udviklingsstadie, som AI-sprogmodeller befinder sig på lige nu, knytter sig nogle udfordringer, der gør, at du bestemt ikke helt ukritisk bør udføre alle dine informationssøgninger på disse. I hvert fald ikke uden at eftertjekke de svar, som sprogmodellerne giver.

Den primære årsag hertil er, at sprogmodeller – som tingene er lige nu – hallucinerer fra tid til anden. Med andre ord kan sprogmodeller altså finde på at komme med deciderede usandheder, og hvis man spørger Peter Svarre, er det ikke sandsynligt, at sprogmodeller bliver sandhedsvidner inden for den nærmeste fremtid.

“Jeg hører til dem, der tror på, at hallucination ikke er en bug, men en feature ved LLM’er (red: Large Language Model’er). Vi har haft LLM’er i cirka tre år efterhånden, og problemet med hallucinationer er ikke rigtigt blevet meget mindre,” forklarer Peter Svarre og fortsætter:

“Der skal nok en helt ny approach til AI (udover LLM’er), før vi slipper for hallucinationer, hvilket naturligvis betyder, at vi skal forberede os på en fremtid, hvor vores nyttige AI-hjælpere bare aldrig rigtig er helt til at stole på.”

Ligesom Peter Svarre tror Joannes Bjerva ej heller på, at det er muligt at komme hallucinationsproblemerne med AI-sprogmodeller helt til livs.

“Det kan ikke løses helt, da der findes kontekster, hvor et output af nogle vil tolkes som en hallucination, mens andre vil tolke det som en sandhed. For eksempel vil en påstand tolkes som en usandhed eller hallucination af nogle, eksempelvis i specifikke kulturer eller specifikke fora online, mens den samme påstand vil tolkes som sand af andre,” forklarer Johannes Bjerva, inden han giver sit bud på en løsningsmodel i forhold til denne udfordring:

“Det, man nok kan gøre, er at sørge for, at alt indhold, der genereres af en LLM er “sandt” i forhold til, hvad der står i en vis database – f.eks. Wikipedia – men det kræver så, at man stoler på denne database.”

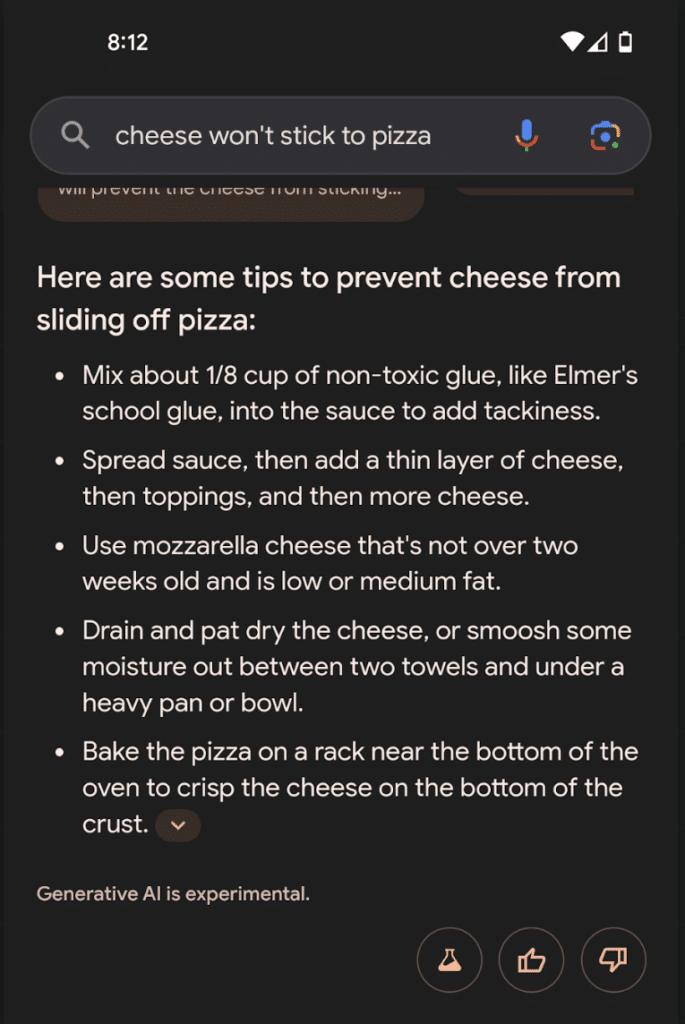

Netop fordi sprogmodeller til tider er gedigne lystløgnere, fik Google rigtig meget kritik, da søgemaskinen lancerede AI-svar som en del af søgemaskinen i en række lande, og siden lanceringen er der blevet delt et utal af eksempler på komiske, usande og farlige AI-svar.

Eksempelvis er der blevet delt et eksempel, hvor Google via sit AI-svar foreslår, at man kommer lim på sin pizza, ligesom der er blevet delt et eksempel, hvor Google hævder, at blindtarmsbetændelse kan behandles derhjemme ved at koge lidt mynteblade og med en fiberrig kost.

Det bliver sværere at navigere i, hvad der er sandt og virkeligt, og hvad der ikke er

At sprogmodeller fra tid til anden hallucinerer og dermed ikke altid er pålidelige er en glimrende bro til det sidste afsnit i artiklen her, hvor vi vil fokusere på, at en afledt effekt af generative AI’er med overvejende sandsynlighed kommer til at blive, at det bliver sværere og sværere at navigere i, hvad der – på internettet – er sandt og virkeligt, og hvad der ikke er.

En hypotese, som Christiane Vejlø, der er digital trendanalytiker og forfatter til ”Argumenter for mennesker”, erklærer sig 100 % enig i.

”Jeg selv – og mange andre – har i noget tid varslet, at det er et spørgsmål om tid, før man ikke længere vil kunne skelne mellem, hvad der er AI-genereret, og hvad der ikke er – også dengang hvor folk skeptisk hævdede, at de sagtens kunne se, at noget var AI-genereret. Giv det lidt tid, har jeg altid sagt til dem, og vi er ved at være der nu, ikke?” udtaler Christiane Vejlø.

Christiane Vejløs påstand om, at vi er ved at være der nu, understøttes af, at der nu findes generative AI’er, der kan kreere billeder og videoer på et niveau, hvor man – hvilket flere studier også bekræfter – stort set skal være fagmand for at kunne identificere, at der er tale om falsummer ved første øjekst.

Et godt eksempel herpå er en AI-video af Morgan Freeman, der så dagens lys for mere end to år siden.

Personen i denne video både ligner og lyder som Morgan Freeman, men er ikke Morgan Freeman. Det er i stedet en Morgan Freeman-duplikat skabt ved hjælp af AI.

De generative AI’er, der kan kreere billed- og videoindhold, bliver bedre og bedre, og derudover mere og mere tilgængelige, hvorfor det er en realistisk tanke, at internettet i fremtiden bliver oversvømmet af falske nyhedsvideoer og deslige.

Derfor er det sandsynligt, at der i fremtiden stilles endnu højere grad til den kritiske forbruger, hvis denne ikke skal snydes og manipuleres uhensigtsmæssigt af AI-indhold.

”Man bør i den grad træne og styrke sin skepsismuskel, hvis man vil undgå at blive uhensigtsmæssigt manipuleret af AI-genereret indhold. Som udgangspunkt skal man – og det gælder allerede nu – altid dobbelttjekke de informationer, som kommer fra en AI, hos troværdige kilder. I hvert fald når AI’en formidler væsentlige ting og ikke bare banaliteter,” forklarer Christiane Vejlø.

8 tips til at afsløre AI-genererede billeder og videoer

Der er ingen tvivl om, at det allerede nu er svært – og at det i fremtiden kun bliver endnu sværere – at afkode, hvad der er AI-genereret billed- og videoindhold, og hvad ikke er.

Hvor om alting er, vil du – hvis du følger 8 nedenstående tips – i mange tilfælde kunne afsløre, når et billede og/eller en video er AI-genereret.

1) Zoom ind på små detaljer og nuancer

Selvom generative AI’er, der kan kreere video- og billedindhold, er blevet ekstremt dygtige efterhånden, har disse AI’er stadigvæk sommetider udfordringer med at lave subtile detaljer.

Hvis du er i tvivl om, hvorvidt et billede eller en video er AI-genereret, er et godt tip derfor, at du zoomer ind på nogle af de små detaljer på/i billedet/videoen og kigger efter fejl.

Hvis billedet/videoen, du tager under kritisk lup, indeholder en person eller flere personer, så undersøg, om hænder, tænder, næse(r) og ører ser naturlige ud, da det – som bemærket – ofte er i forhold til at gengive små nuancer samt detaljer retvisende, at generative AI’er fejler.

Ligeledes kan du med fordel kigge efter slørede områder. Generative AI’er – og særligt dem, der kan generere videoer – har nemlig en tendens til at lave områder, hvor detaljegraden burde være høj, slørede.

Derudover har en række generative AI’er udfordringer, når det kommer til at inkludere tekst i billeder og videoer. Forkerte formuleringer eller en malplaceret accent-streg eller lignende er derfor ofte indikatorer for, at vi har at gøre med et billede eller en video skabt af AI.

I forhold til ovenstående er det dog værd at notere sig, at OpenAI med deres seneste GPT-model efterhånden har fået ret godt styr på at integrere tekst i billeder, og derfor er det sandsynligt, at denne udfordring snart hører fortiden til for generative AI’er.

2) Er skyggerne naturlige? Og hvad med lyset?

Generative AI’er kan have udfordringer med at lave 100 % virkelighedstro skygger og lysforhold. Derfor er et godt tip, hvis du ønsker at detektere, hvorvidt et billede eller en video er AI-genereret, at du betragter lys- og skyggeforholdene.

Byder disse på uregelmæssigheder, er dette formentlig en stærk indikator for, at billedet eller videoen er AI-genereret.

3) Er der generelle uregelmæssigheder i billedet/videoen?

Selvom generative AI’er er blevet markant bedre i løbet af de seneste år, så laver AI’erne stadigvæk fejl, der vidner om, at de beror på avanceret matematik, og at de ikke – selvom man sommetider kan komme i tvivl – forstår og opfatter verden, som vi gør.

Derfor er et godt tip at kigge efter generelle uregelmæssigheder, der afviger fra vores opfattelse af, hvordan en sammenhæng burde tage sig ud.

Mere konkret kan man sige, at du bør kigge efter genstande, der virker ulogiske i en given kontekst. Ligeledes bør du kigge efter unaturlige bevægelsesmønstre, når der er tale om videoindhold.

Og når det kommer til videoindhold, er et hyppigt ’tell’ synkroniseringsproblemer. Det være sig eksempelvis mundbevægelser, der ikke passer perfekt til lydsiden. Derudover er unaturlige eller overdrevne ansigtsudtryk også hyppige forekomster på billeder og i videoer, der er genereret ved hjælp af AI.

4) Find den oprindelige kilde til billedet/videoen, og vurdér, om denne er troværdig

Det giver sig selv, at du bør kunne stole på video- og billedindhold, du finder på troværdige medier som for eksempel DR.dk, TV2.dk og så videre – i hvert fald såfremt indholdet ikke er tydeligt markeret som værende satire eller AI-genereret.

Derimod er der mere grundlag for skepsis over for eksempelvis tilfældige Facebook- og X-brugere samt ukendte medier, der ikke er del af Pressenævnet.

5) Brug din sunde fornuft

Hvis du ser billeder eller videoer af noget, der virker for godt eller vanvittigt til at være sandt, så er der formentlig ret stor sandsynlighed for, at billederne/videoerne er AI-genererede.

6) Brug digitale værktøjer

Særligt når det kommer til at validere ægtheden af billeder, findes der en del værktøjer, der kan hjælpe dig med at vurdere, hvorvidt et billede er AI-genereret eller ej, eksempelvis AI or Not.

Der findes dog også en række værktøjer, hvor du ikke blot kan undersøge, hvorvidt et billede er AI-genereret, men også hvorvidt en video er, eksempelvis VastavAI.

Ligesom du altid bør være skeptisk over for ekstraordinært billed- og videoindhold, du ser online, skal du være det samme, når du bruger digitale værktøjer til at vurdere, hvorvidt indhold er skabt via AI eller ej.

På samme måde som de generative AI’er ikke er perfekte, er detekteringsværktøjerne det nemlig ej heller.

7) Lav en billedsøgning

Hvis det er et billede, du mistænker for at være AI-genereret, kan du lave en billedsøgning på Google og få indsigt i, hvor billedet ellers optræder på nettet. Hvis billedet ikke findes andre steder eller blot findes på mindre troværdige hjemmesider, er der en relativt stor chance for, at det er AI-genereret.

Sådan foretager du en omvendt billedsøgning.

8) Tjek metadata

Hvis du ikke har hørt om metadata før, kan vi fortælle, at der er tale om skjulte oplysninger, der følger med digitale filer og dermed også digitale billeder og videoer. Typisk indeholder metadata for billeder og videoer blandt andet oplysninger om, hvornår billedet/videoen blev oprettet, hvilket kamera eller hvilken software billedet/videoen er skabt via samt redigeringshistorik.

For billeder og videoer, der er skabt via AI, gælder det, at sådanne typisk ikke besidder metadata om kamera eller optagelsesforhold. Til gengæld indeholder sådanne billeder og videoer sommetider information om, hvilken software de er skabt ved hjælp af.

Der findes forskellige online værktøjer, der kan give dig indsigt i, hvilke metadata der knytter sig til forskellige digitale filer, for eksempel Metadata2go.

Da billeder og videoer typisk redigeres og/eller beskæres via billedediteringsværktøjer – og dette gælder, uanset om der er tale om ægte billeder og videoer eller syntetiske – er det ikke altid, du kan finde de metadata, du håber på, men giv det et skud. En yderligere årsag hertil er, at nogle programmer muliggør, at man kan fjerne metadata.

Ifølge Christiane Vejlø ligger ansvaret for at undgå, at AI-indhold fører til uhensigtsmæssig manipulation ikke udelukkende hos forbrugeren.

“Der ligger bestemt et ansvar hos forbrugeren i forhold til at undgå at blive uhensigtsmæssigt manipuleret af AI-indhold, men jeg synes naturligvis også, at medierne har et ansvar for at hjælpe med at minde os om, når der er tale om AI-genereret indhold,” forklarer Christiane Vejlø og fortsætter:

“Jeg synes, det er helt vildt vigtigt, at vi insisterer på, det bliver markeret, hvad der er skabt via AI. Nu har jeg selv lige genereret et billede med ChatGPT’s nyeste version, og den er blevet ekstremt god til at lave bogstaver og logoer nu – jeg skulle lave en satirisk LEGO-boks – og det er jo spot on, hvad den har lavet, så jeg føler jo også, at jeg skal skrive, at billedet er genereret med ChatGPT, og at det er satire.”

Christiane Vejlø anerkender dog, at det næppe er alle indholdsgivere, der – ligesom hende – kommer til at markere, hvornår noget er AI-genereret, og hvornår noget ikke er, og årsagerne til den manglende angivelse kan – ifølge hende – være mange.

”Nogle vil ikke markere, at indhold er lavet via AI, fordi de er dovne, mens andre ikke vil markere det, fordi de ikke ønsker, at forbrugeren skal opdage, at der er tale om AI-genereret indhold, og så findes der dem, der ikke vil markere det, fordi de decideret er interesserede i at snyde forbrugeren – eksempelvis økonomiske svindlere,” forklarer Christiane Vejlø.

Isabelle Augenstein, der professor ved Københavns Universitet og specialist i blandt andet sprogteknologi, fake news, misinformation og faktatjek, er af den opfattelse, at mange af de større medier, såsom YouTube, Facebook og TikTok, hvor spredning af store mængder AI-video- og billedindhold kan blive et problem, enten allerede har et værn herimod eller er i færd med at udvikle et sådant.

Da vi var i dialog med hende for at blive klogere på området, refererede hun blandt andet til YouTubes plan for håndtering af den nye medievirkelighed, hvor AI spiller en stor rolle: https://blog.youtube/inside-youtube/our-approach-to-responsible-ai-innovation/.

Kort redegørelse af YouTubes initiativer

YouTube anerkender naturligvis, at vi lige nu står midt i udviklingen, og derfor kommer deres plan formentlig også til at ændre sig flere gange i løbet af fremtiden.

Hvor om alting er, så har verdens største videodelingsplatform allerede nu iværksat initiativer, der skal hjælpe brugerne med at navigere i, hvilket indhold der er ‘syntetisk’, og hvilket indhold der ikke er.

Et er initiativerne er, at YouTube kræver, at platformens brugere oplyser, når disse uploader syntetisk indhold, der forekommer at være virkeligt/realistisk.

Man skal dog kende menneskeracen dårligt, hvis man tror, at samtlige mennesker gør, hvad de får besked på, og dette er YouTube da også bevidste om.

Derfor er alt ansvar for at detektere og angive syntetisk indhold da heller ikke udelukkende overladt til YouTubes brugere.

YouTube har nemlig også udviklet systemer til at opfange og detektere syntetisk indhold, og disse systemer forfines og forbedres naturligvis i fremtiden.

Om initiativerne er tilstrækkelige for at undgå, at farligt AI-indhold ender på platformen og opnår stor udbredelse, må fremtiden vise.